За последнее время все чаще слышу разговоры о 'умных' дата-центрах, о системах, которые сами решают проблемы. И это прекрасно, но часто понимание 'умности' сводится к простому сбору данных. Я бы сказал, что настоящая ценность – не в данных сами по себе, а в их анализе и автоматизированном реагировании на возникающие аномалии. Ведь красивый график температуры без автоматического отключения неисправного сервера – это, мягко говоря, не очень полезно. На самом деле, попытки автоматизировать все сразу часто приводят к перегрузке системы и, как следствие, к еще большим проблемам. Важно подходить к созданию интеллектуальной системы мониторинга и обслуживания серверных помещений системно, от выявления критических узких мест до тонкой настройки автоматических действий.

В сфере серверных и сетевых технологий постоянно растет объем собираемых данных. Изначально все хотели мониторить все подряд – от напряжения в розетке до загрузки отдельных ядер процессора. Это, конечно, полезно, но быстро превращается в гору информации, которую сложно анализировать и из которой получить ценные выводы. Часто возникает ситуация, когда система генерирует огромное количество оповещений, большая часть из которых – ложные срабатывания. Это приводит к тому, что операторы просто перестают обращать внимание на оповещения, а реальные проблемы остаются незамеченными до тех пор, пока не приведут к серьезным последствиям. Например, мы сталкивались с ситуацией, когда система сигнализировала о перегреве одного из серверов несколько раз в день, в то время как реальная проблема была связана с недостаточным потоком воздуха в серверной, что мы не заметили среди потока ложных тревог. Попытки автоматизировать реагирование на все эти 'аномалии' приводят к еще большей путанице и, как итог, к замедлению работы системы и увеличению нагрузки на операторов.

Иногда, проще просто сказать: “Всё работает, не трогайте”. Это может показаться контринтуитивным, но часто в стабильных системах, при правильно настроенных оповещениях, агрессивное автоматическое вмешательство лишь ухудшает ситуацию. Более эффективным подходом является установка пороговых значений и исключений для определенных ситуаций. Например, не стоит реагировать на незначительное повышение температуры, но следует немедленно вызывать оповещение, если температура превышает критический уровень или если она повышается слишком быстро. Задача системы мониторинга – не просто собирать данные, а помогать оператору принимать обоснованные решения на основе анализа этих данных.

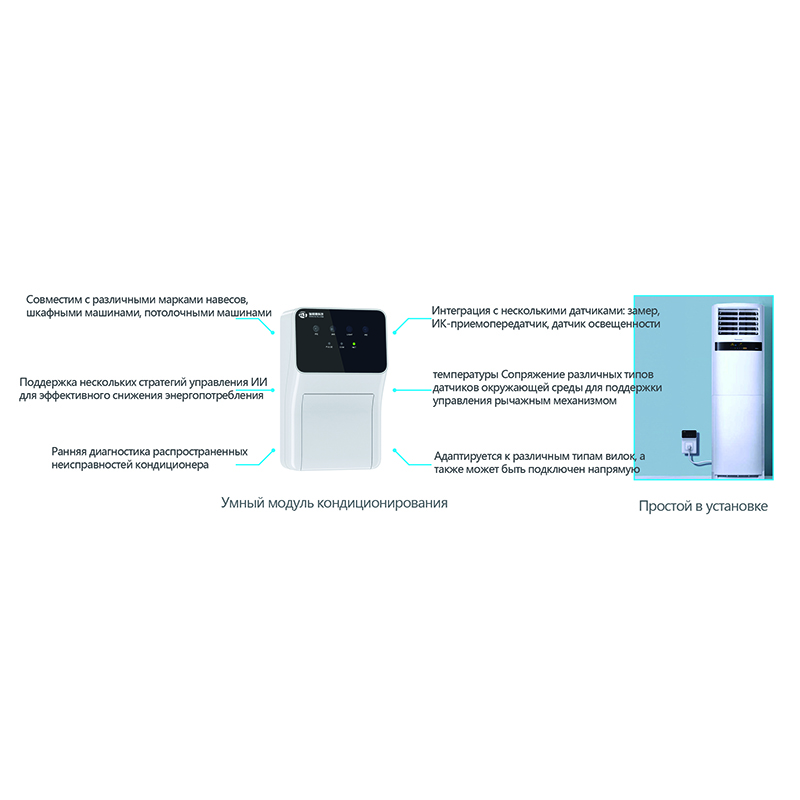

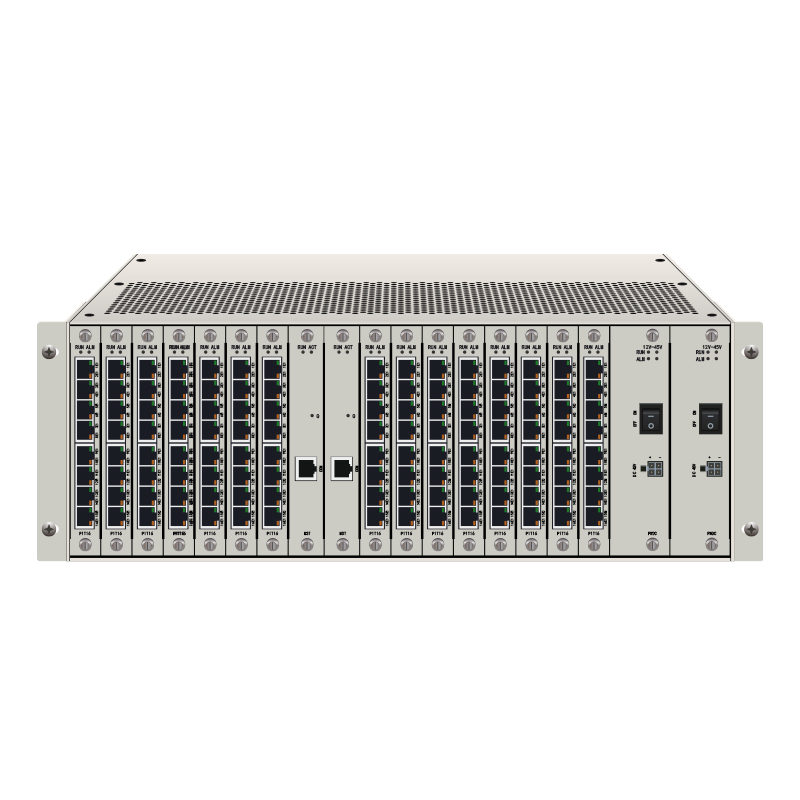

Я бы выделил несколько ключевых компонентов, которые необходимы для создания действительно эффективной системы мониторинга и обслуживания серверных помещений. Во-первых, это надежный датчик, способный точно измерять параметры окружающей среды – температуру, влажность, уровень шума, напряжение в сети. Не стоит экономить на датчиках, так как их неточность может привести к ложным срабатываниям или, наоборот, к пропуску реальных проблем. Во-вторых, это мощная платформа сбора и анализа данных, способная обрабатывать огромные объемы информации в реальном времени. Третий важный компонент – это система оповещений, которая должна быть гибкой и настраиваемой, чтобы операторы могли получать оповещения только о тех событиях, которые действительно требуют их внимания. И, наконец, четвертый компонент – это система автоматического реагирования, которая должна быть хорошо протестирована и проверена на различных сценариях.

Недостаточно просто собирать и отображать текущие параметры. Важно анализировать исторические данные, чтобы выявлять тенденции и прогнозировать возможные проблемы. Например, если мы видим, что температура на одном из серверов постоянно повышается в определенное время суток, это может указывать на проблему с вентиляцией или на необходимость оптимизации загрузки сервера. Предиктивная аналитика позволяет прогнозировать возможные сбои оборудования, основываясь на анализе данных о его производительности и состоянии. Такой подход позволяет проводить профилактические работы, предотвращая серьезные проблемы и сокращая время простоя.

Очень важно, чтобы система мониторинга была интегрирована с другими системами управления инфраструктурой, такими как системы управления серверами (например, VMware vCenter) и системы управления сетью. Это позволяет автоматизировать многие задачи, такие как перезагрузка серверов, переключение трафика, и обновление программного обеспечения. Например, если система мониторинга обнаруживает, что сервер перегружен, она может автоматически перезагрузить его или переключить трафик на другой сервер. Такая интеграция позволяет значительно сократить время реагирования на проблемы и повысить стабильность работы системы.

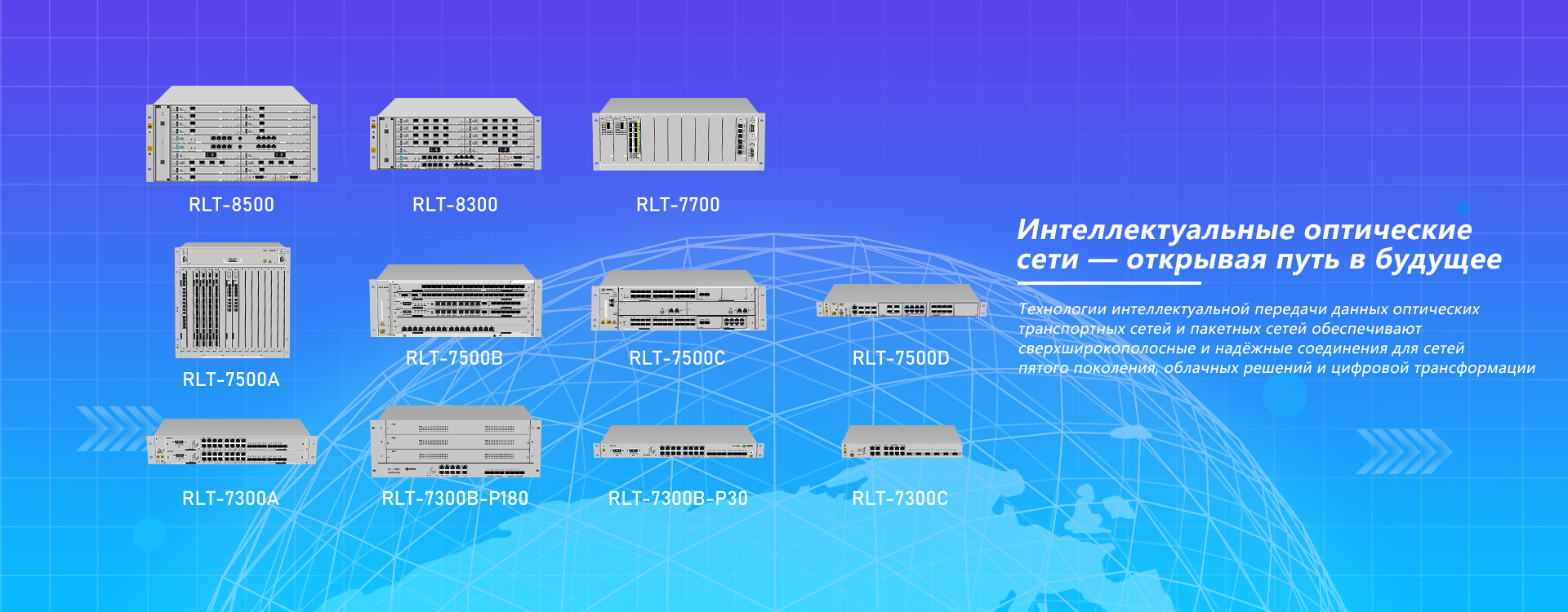

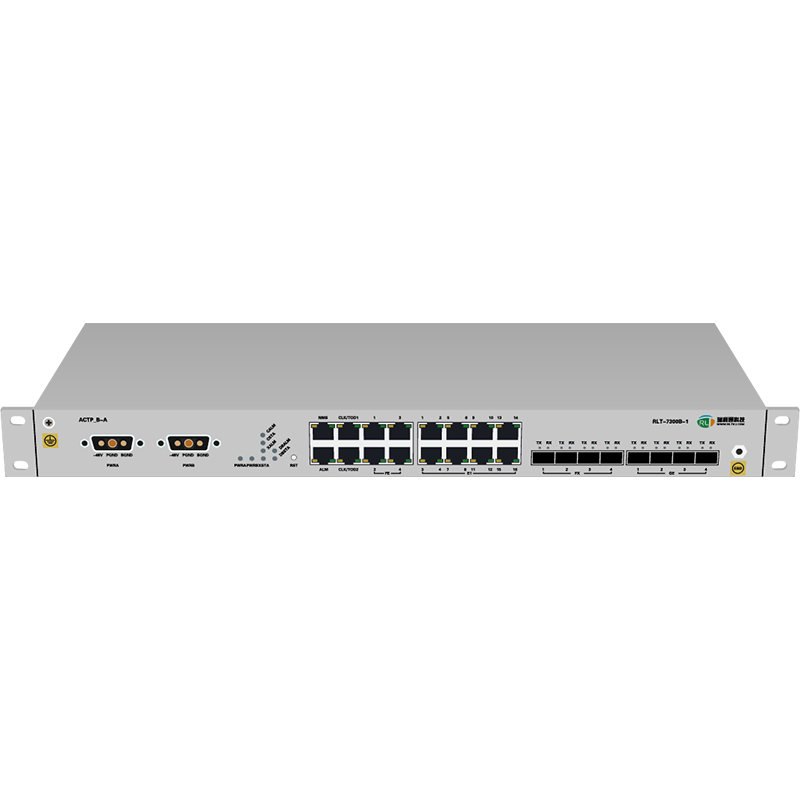

В одной из наших компаний (ООО Тяньцзинь Жуйлитун Технолоджи) мы реализовали интеллектуальную систему мониторинга и обслуживания серверных помещений для дата-центра крупного интернет-провайдера. Основная задача была – оптимизация энергопотребления. Изначально система просто собирала данные о температуре, влажности и энергопотреблении серверов. Но потом мы добавили возможность анализа энергопотребления по отдельным серверам и приложениям. Это позволило нам выявить, что некоторые приложения потребляют значительно больше энергии, чем другие. Мы отключили неиспользуемые приложения и оптимизировали конфигурацию серверов, что привело к сокращению энергопотребления на 15%. Кроме того, мы настроили автоматическое снижение производительности серверов в периоды низкой нагрузки, что также позволило сократить энергопотребление. Это был достаточно простой, но эффективный пример того, как можно использовать системы мониторинга и обслуживания для решения практических задач.

Несмотря на все достижения в области интеллектуальной системы мониторинга и обслуживания серверных помещений, остаются определенные вызовы. Одним из основных вызовов является необходимость интеграции различных систем и устройств, которые используют разные протоколы и форматы данных. Кроме того, важно обеспечить безопасность системы, чтобы предотвратить несанкционированный доступ к данным и автоматическому управлению. В будущем я думаю, что системы мониторинга и обслуживания станут еще более интеллектуальными и автономными. Они будут использовать машинное обучение и искусственный интеллект для прогнозирования проблем, оптимизации производительности и автоматизации принятия решений.

Более того, сейчас появляется все больше решений, основанных на принципах цифрового двойника. Создание виртуальной копии дата-центра позволяет тестировать различные сценарии и оптимизировать работу системы без риска для реальной инфраструктуры. По сути, это 'лаборатория' для экспериментов и поиска оптимальных настроек. Как компания, занимающаяся предоставлением комплексных решений в области связи (как указано на нашем сайте